Modèles Markov Chain Monte Carlo (MCMC)-Prédire les buts de football

Markov Chain Monte Carlo (MCMC) est une méthode statistique utilisée pour échantillonner à partir de distributions de probabilité complexes. Bien que MCMC ne soit pas une méthode de prédiction directe, il peut être utilisé en combinaison avec des modèles hiérarchiques bayésiens pour estimer les paramètres et faire des prédictions, comme le nombre de buts de football dans un match.

Voici un aperçu général de la façon d'utiliser MCMC en combinaison avec un modèle hiérarchique bayésien pour prédire les objectifs de football:

Collecter des données historiques: rassembler des données sur les matchs passés, y compris le nombre de buts marqués par chaque équipe, leurs forces offensives et défensives, l'avantage à domicile et d'autres facteurs pertinents qui peuvent influencer le score de buts.

Définir le modèle hiérarchique bayésien: Mettre en place un modèle hiérarchique bayésien en utilisant des prédicteurs pertinents. Les prédicteurs courants incluent la force de l'équipe (attaque et défensive), l'avantage à domicile et les records en tête-à-tête. Dans un cadre bayésien, vous définiriez des distributions antérieures pour chacun de ces paramètres, en fonction de la connaissance du domaine ou en utilisant des priors non informatifs si l'on en sait peu sur les paramètres.

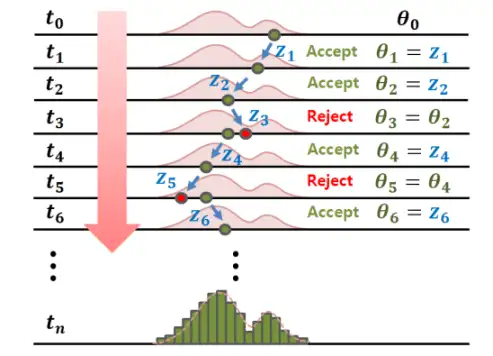

Estimer les paramètres à l'aide de MCMC: Utilisez des algorithmes MCMC comme l'échantillonnage Metropolis-Hastings ou Gibbs pour échantillonner à partir de la distribution postérieure des paramètres donnés. Ce processus vous aide à estimer la distribution des paramètres conditionnés aux données observées.

Faites des prédictions: utilisez la distribution postérieure des paramètres pour faire des prédictions pour une correspondance à venir. Vous pouvez le faire en échantillonnant à partir de la distribution prédictive du nombre d'objectifs pour chaque équipe, compte tenu des paramètres estimés. Cela vous fournira une gamme de résultats possibles et leurs probabilités associées.

Évaluez l'exactitude: comparez vos prédictions aux résultats réels des correspondances pour évaluer la précision de votre modèle. Affinez votre modèle au besoin en ajustant les variables prédictives, les distributions antérieures ou en incorporant des données supplémentaires.

L'avantage d'utiliser MCMC en combinaison avec un modèle hiérarchique bayésien est qu'il fournit une estimation plus robuste des paramètres en tenant compte de l'incertitude dans les valeurs des paramètres. De plus, il vous permet d'incorporer des connaissances ou des croyances antérieures sur les paramètres, ce qui peut améliorer les prédictions lorsque les données sont limitées.

Cependant, les modèles basés sur MCMC peuvent être intensifs en calcul, en particulier avec de grands ensembles de données ou des modèles complexes. Cela peut les rendre plus lents à exécuter et plus difficiles à implémenter que des méthodes plus simples comme la régression de Poisson.

Démontrons un exemple simplifié d'utilisation d'un algorithme de Markov Chain Monte Carlo (MCMC) en combinaison avec un modèle hiérarchique bayésien pour prédire les buts de football dans un match à venir entre l'équipe A et l'équipe B.

Collecter des données historiques: Supposons que nous ayons les données suivantes des cinq derniers matches pour les deux équipes:

Objectifs de l'équipe A: 2, 1, 0, 3, 1

Buts de l'équipe B: 1, 2, 2, 0, 1

Définissez le modèle hiérarchique bayésien: Pour cet exemple, nous considérerons un modèle simple où le nombre de buts marqués par chaque équipe suit une distribution de Poisson avec un paramètre lambda (λ). Nous supposerons que le lambda de chaque équipe suit une distribution Gamma avec des paramètres alpha (α) et bêta (β). En pratique, vous devez intégrer des facteurs supplémentaires tels que la force de l'équipe, les records en tête-à-tête, etc.

Configurez des distributions antérieures: nous choisirons des priors non informatifs pour les paramètres α et β de la distribution Gamma. Par exemple, nous pouvons utiliser α = β = 1.

Estimer les paramètres à l'aide de MCMC: Appliquer un algorithme MCMC (par exemple, échantillonnage Metropolis-Hastings ou Gibbs) pour échantillonner à partir de la distribution postérieure des paramètres compte tenu des données observées. Dans cette étape, l'algorithme MCMC génère de manière itérative des échantillons de lambda (λ) pour chaque équipe, en tenant compte des données observées et des distributions antérieures.

Faites des prédictions: Après avoir obtenu les échantillons de la distribution postérieure de lambda (λ) pour chaque équipe, utilisez ces échantillons pour générer des prédictions sur le nombre de buts dans le match à venir. Par exemple, si les échantillons postérieurs du lambda de l'équipe A (λ_A) sont [1.6, 1.5, 1.7, 1.4, 1.6], vous pouvez calculer la distribution prédictive du nombre de buts marqués par l'équipe A en échantillonnant à partir d'une distribution de Poisson avec chaque valeur lambda.

Évaluer la précision: Après le match, comparez le nombre de buts prévu au nombre réel de buts marqués. Gardez une trace de la précision de la prédiction au fil du temps et affinez le modèle au besoin.

Cet exemple démontre les étapes de base impliquées dans l'utilisation de MCMC avec un modèle hiérarchique bayésien pour la prédiction des buts de football. Gardez à l'esprit que cet exemple est simplifié, et vous devriez inclure plus de variables prédictives et utiliser un ensemble de données plus grand pour des prédictions plus précises. De plus, les algorithmes MCMC peuvent être gourmands en calcul, de sorte que leur mise en œuvre dans la pratique peut nécessiter une optimisation supplémentaire ou des ressources informatiques plus puissantes.