Modelos de Markov Chain Monte Carlo (MCMC)-Predecir goles de fútbol

Markov Chain Monte Carlo (MCMC) es un método estadístico utilizado para el muestreo de distribuciones de probabilidad complejas. Aunque MCMC no es un método de predicción directa, se puede utilizar en combinación con modelos jerárquicos bayesianos para estimar parámetros y hacer predicciones, como la cantidad de goles de fútbol en un partido.

Aquí hay un esquema general de cómo usar MCMC en combinación con un modelo jerárquico bayesiano para predecir goles de fútbol:

Recopile datos históricos: recopile datos sobre partidos anteriores, incluida la cantidad de goles marcados por cada equipo, sus fortalezas de ataque y defensiva, ventaja de local y otros factores relevantes que pueden influir en la puntuación de goles.

Defina el modelo jerárquico bayesiano: establezca un modelo jerárquico bayesiano utilizando predictores relevantes. Los predictores comunes incluyen la fuerza del equipo (ataque y defensiva), la ventaja de jugar en casa y los registros cara a cara. En un marco bayesiano, definiría distribuciones anteriores para cada uno de estos parámetros, basándose en el conocimiento del dominio o utilizando priores no informativos si se sabe poco sobre los parámetros.

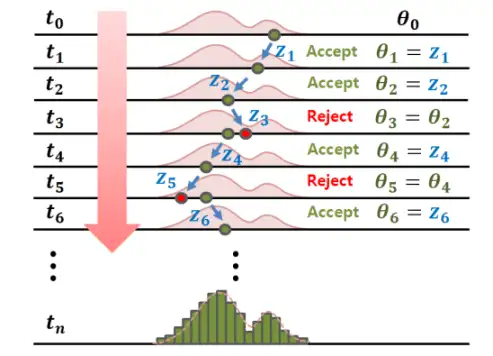

Estimar parámetros utilizando MCMC: Utilice algoritmos MCMC como el muestreo de Metropolis-Hastings o Gibbs para muestrear desde la distribución posterior de los parámetros dados los datos. Este proceso le ayuda a estimar la distribución de los parámetros condicionados a los datos observados.

Haga predicciones: use la distribución posterior de los parámetros para hacer predicciones para un próximo partido. Puede hacer esto mediante el muestreo de la distribución predictiva del número de objetivos para cada equipo, dados los parámetros estimados. Esto le proporcionará una variedad de posibles resultados y sus probabilidades asociadas.

Evaluar la precisión: Compare sus predicciones con los resultados reales de las coincidencias para evaluar la precisión de su modelo. Refine su modelo según sea necesario ajustando variables de predictor, distribuciones anteriores o incorporando datos adicionales.

La ventaja de usar MCMC en combinación con un modelo jerárquico bayesiano es que proporciona una estimación más sólida de los parámetros al tener en cuenta la incertidumbre en los valores de los parámetros. Adicionalmente, permite incorporar conocimientos previos o creencias sobre los parámetros, lo que puede mejorar las predicciones cuando los datos son limitados.

Sin embargo, los modelos basados en MCMC pueden ser computacionalmente intensivos, especialmente con grandes conjuntos de datos o modelos complejos. Esto puede hacerlos más lentos de ejecutar y más difíciles de implementar que métodos más simples como la regresión de Poisson.

Demostremos un ejemplo simplificado del uso de un algoritmo Markov Chain Monte Carlo (MCMC) en combinación con un modelo jerárquico bayesiano para predecir goles de fútbol en un próximo partido entre el Equipo A y el Equipo B.

Recopilar datos históricos: Supongamos que tenemos los siguientes datos de los últimos cinco partidos para ambos equipos:

Goles del equipo A: 2, 1, 0, 3, 1

Goles del equipo B: 1, 2, 2, 0, 1

Definir el modelo jerárquico bayesiano: para este ejemplo, consideraremos un modelo simple donde el número de goles marcados por cada equipo sigue una distribución de Poisson con un parámetro lambda (λ). Supondremos que la lambda de cada equipo sigue una distribución gamma con parámetros alfa (α) y beta (β). En la práctica, debe incorporar factores adicionales como la fuerza del equipo, los registros de cabeza a cabeza, etc.

Configurar distribuciones anteriores: elegiremos priores no informativos para los parámetros α y β de la distribución Gamma. Por ejemplo, podemos usar α = β = 1.

Estimar parámetros utilizando MCMC: Aplique un algoritmo MCMC (por ejemplo, muestreo de Metropolis-Hastings o Gibbs) para tomar muestras de la distribución posterior de los parámetros dados los datos observados. En este paso, el algoritmo MCMC genera iterativamente muestras de lambda (λ) para cada equipo, teniendo en cuenta los datos observados y las distribuciones anteriores.

Haga predicciones: después de obtener las muestras de la distribución posterior de lambda (λ) para cada equipo, use estas muestras para generar predicciones sobre el número de goles en el próximo partido. Por ejemplo, si las muestras posteriores para la lambda del equipo A (λ_A) son [1,6, 1,5, 1,7, 1,4, 1,6], puede calcular la distribución predictiva del número de goles anotados por el equipo A mediante un muestreo de una distribución de Poisson con cada valor lambda.

Evaluar la precisión: después del partido, compare el número previsto de goles con el número real de goles marcados. Mantenga un registro de la precisión de la predicción a lo largo del tiempo y perfeccione el modelo según sea necesario.

Este ejemplo demuestra los pasos básicos involucrados en el uso de MCMC con un modelo jerárquico bayesiano para la predicción de goles de fútbol. Tenga en cuenta que este ejemplo está simplificado y debe incluir más variables de predictor y usar un conjunto de datos más grande para predicciones más precisas. Además, los algoritmos MCMC pueden ser computacionalmente intensivos, por lo que implementarlos en la práctica podría requerir una optimización adicional o recursos informáticos más potentes.